MM1 : le modèle d’IA multimodal d’Apple très doué pour l’analyse d’images

Apple continue de distiller ses efforts dans le domaine de l’IA à travers différents papiers de recherche. Après Ferret ou MGIE, l’entreprise a récemment levé le voile sur MM1, un nouveau modèle multimodal pouvant travailler avec du texte et de l’image.

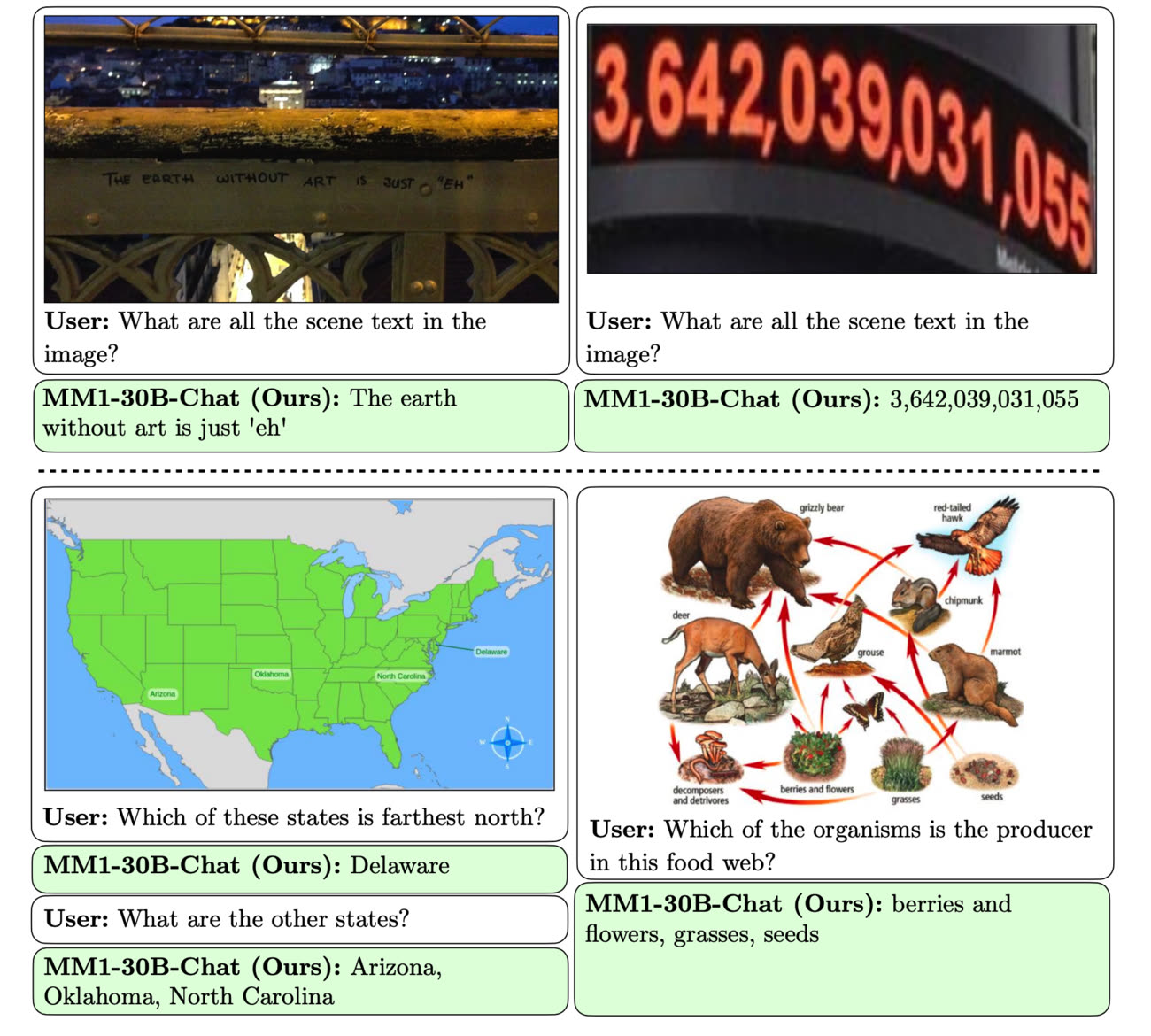

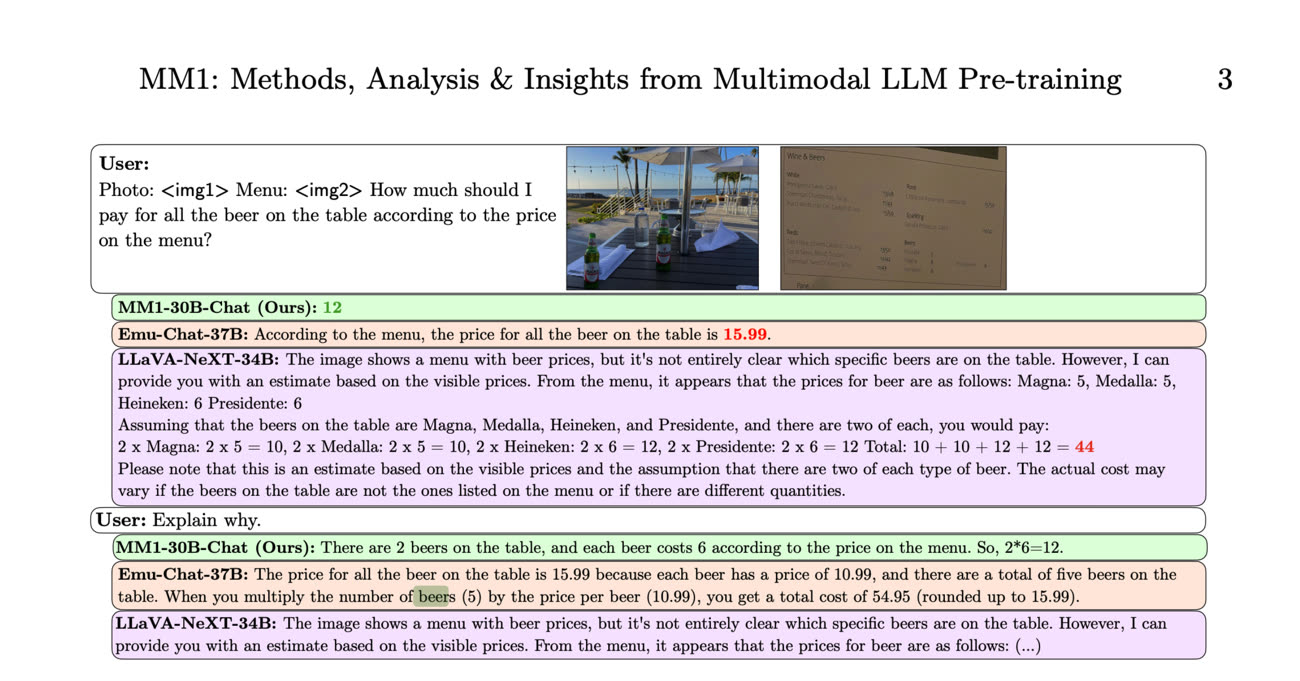

MM1 peut répondre à des demandes naturelles pouvant porter sur des photos. Le papier de recherche donne un exemple où on lui montre un cliché représentant une table sur laquelle sont posées plusieurs bouteilles de bière avant de lui montrer un menu de restaurant. On lui demande ensuite combien il faut s’attendre à payer pour tout cela, ce à quoi le modèle répond correctement. On peut aussi voir MM1 décrire l’ambiance d’une image de manière détaillée, ou effectuer différentes déductions logiques. Le modèle est également sollicité pour aider à utiliser une machine à café, et se débrouille bien pour répondre à plusieurs requêtes à la suite.

Ce type de modèle est similaire sur certains points au Llama de Meta ou au Gemini de Google. Il peut servir à alimenter un chatbot général ou plus spécifique, par exemple en effectuant des actions. On peut imaginer que la nouveauté finira par trouver sa place dans l’écosystème Apple, comme pour décrire des photos ou des documents. Ce type de technologie ouvre notamment de nombreuses portes dans le domaine de l’accessibilité.

Be My AI : quand GPT-4 décrit fidèlement l'environnement des personnes aveugles

Le modèle est composé d’une famille de différentes tailles, globalement assez petit si l’on se fie à leur nombre des paramètres. Les chercheurs expliquent obtenir tout de même de bons résultats grâce à un gros travail d’optimisation. Le but est sans doute de le faire tourner en local sans passer par le nuage, ce qui est un bon point niveau confidentialité. Cela demande cependant pas mal de puissance sous le capot : il semblerait qu’Apple envisage des déclinaisons mettant le paquet sur l’IA pour ses prochaines puces de smartphone.

Vivement la puce A20 pour iPhone 18 … dans qlqs temps 😮💨

@fleeBubl,

Bonjour Fred,

« Vivement la puce A20 pour iPhone 18 … dans qlqs temps 😮💨 »

L'IA version Apple sera locale ou pas !

Apple n'a pas investi dans une infrastructure digne de ce nom pour traiter les requêtes dans le nuage !

Du coup, Apple n'a comme unique alternative que le traitement local vendu comme protection ultime de nos données avec des processeurs comportant une faille matérielle de sécurité !

Cherchez l'erreur…

🤪

@Scooby-Doo

"Du coup, Apple n'a comme unique alternative que le traitement local vendu comme protection ultime de nos données avec des processeurs comportant une faille matérielle de sécurité !"

Comme les serveurs distants. 🤣 Moins, mais en local me convient bien.

@Gwynpl@ine,

« Comme les serveurs distants. »

Votre affirmation laisse à supposer que la maintenance locale serait supérieure à une maintenance sur serveurs !

Dans les faits, c'est exactement l'inverse !

👌

À part vouloir que sa batterie fonde comme neige en plein cagnard et utiliser les ressources de son terminal juste pour faire de l'IA, je n'y vois que des inconvénients !

😁

@Scooby-Doo

"je n'y vois que des inconvénients !"

Sauf:

- fonctionnement hors connexion

- confidentialité (crucial pour certains métiers)

@DahuLArthropode,

« Sauf : fonctionnement hors connexion ; confidentialité (crucial pour certains métiers) »

👍

Effectivement ce sont deux excellents exemples.

Mais il faut alors accepter les conséquences :

- réduction de la durée d'utilisation parce que cela consomme beaucoup d'énergie ;

- maintenance locale !

J'utilise depuis des années des IA à domaine restreint avec modèles à télécharger et exécuter en local !

Je ne vous dit même pas le volume de données à télécharger pour maintenir les modèles à jour !

Cela se calcule en dizaine de Go par mois !

Il n'y a pas que la batterie qui va fondre mais aussi le forfait data !

👌

@Gwynpl@ine

Pourtant il n’y a quasiment que des inconvénient en local…

@armandgz123,

« Pourtant il n’y a quasiment que des inconvénient en local… »

👍

J'explique celà depuis un moment, mais sans résultat…

😭

@Scooby-Doo

C’est certes plus facile de maintenir une IA sur un serveur que sur X téléphones.

Après, je me dis que je préfère payer le tel plus cher que de devoir me trimballer un abonnement supplémentaire pour utiliser cette IA, parce que j’imagine qu’Apple aurait répercuté le fonctionnement des serveurs d’une manière ou d’une autre par un abonnement. C’est ce que fait la concurrence d’ailleurs.

@roccoyop,

« Après, je me dis que je préfère payer le tel plus cher que de devoir me trimballer un abonnement supplémentaire pour utiliser cette IA, parce que j’imagine qu’Apple aurait répercuté le fonctionnement des serveurs d’une manière ou d’une autre par un abonnement. C’est ce que fait la concurrence d’ailleurs. »

👍

Vous avez un excellent argument en effet !

👌

@roccoyop

Ne pas payer d’abonnement peut être intéressant, mais à condition (pour moi) que l’IA évolue aussi vite que celle sur serveur ! Même après 5 ans

Je vois une une très grosse différence avec les autres "modèles", c'est la possibilité de demander "Explain why" comme on peut le voir dans la dernière copie d'écran.

Expliquer ses résultats, ChatGPT est incapable de le faire.

@marc_os,

« Je vois une une très grosse différence avec les autres "modèles", c'est la possibilité de demander "Explain why" comme on peut le voir dans la dernière copie d'écran. »

🤪

Les autres LLM le font aussi et depuis le début !

Faut juste prendre le temps de leur demander !

C'est d'ailleurs comme cela que l'on arrive à remonter dans leur “mémorisation”…

👌

@ Scooby-Doo

> Les autres LLM le font aussi et depuis le début !

Je ne l'ai jamais vu.

Pourriez-vous nous montrer ce que donnent les explications fournies par ChatGPT après avoir livré un résultat ?

Merci.

@marc_os,

« Pourriez-vous nous montrer ce que donnent les explications fournies par ChatGPT après avoir livré un résultat ? »

Déjà fait sur ce forum !

Je lui demandé de me générer une énigme à résoudre par la logique ! Puis elle m'a expliqué la résolution de l'énigme qu'elle avait générée !

😎

@ Scooby-Doo

Merci pour cette réponse parfaitement inutile.

Je n'en attendais pas moins de votre part.

🤪

@marc_os

Entre les test en interne et la version grand public c’est pas la meme

@SidFik,

« Entre les test en interne et la version grand public c’est pas la meme »

👍

Tellement vrai !

🙄

En tout cas les explications données par « les autres » modèles, sur cet exemple, sont fausses.

Mais rien ne prouve qu’il n’existe pas de cas totalement opposés.

@Mac1978

Oui, c’est pour ça qu’il y a des benchmark assez standard, avec des centaines de test, plutôt que de prendre quelques exemples qui fonctionnent…

Mais comme d’habitude avec Apple, il vaut mieux ne pas se fier à ce qui est plus un papier de recherche marketing qu’autre chose et plutôt attendre que des utilisateurs aient le modèle entre les mains pour avoir un retour a minima objectif.

@redchou,

« Mais comme d’habitude avec Apple, il vaut mieux ne pas se fier à ce qui est plus un papier de recherche marketing qu’autre chose et plutôt attendre que des utilisateurs ait le modèle entre les mains pour avoir un retour a minima objectif. »

👍

Et c'est à ce moment là que les problèmes commencent en principe !

😁

@Mac1978,

« En tout cas les explications données par « les autres » modèles, sur cet exemple, sont fausses. Mais rien ne prouve qu’il n’existe pas de cas totalement opposés. »

C'est une technique connue sous le nom de “cherry picking” en Anglais !

On sélectionne les exemples qui vont bien pour son produit et ridiculisent la concurrence !

Business as usual…

😎

Je croyais qu'Apple était larguée sur l'IA...

@smog,

« Je croyais qu'Apple était larguée sur l'IA... »

Elle l'est totalement !

Elle a au moins 7 ans de retard sur les travaux publiés par Google !

MM1 est tout sauf une nouveauté !

Mais c'est rassurant de voir qu'ils travaillent sur le sujet. Et c'est encourageant…

👌

Par contre, préparez-vous à voir la durée de votre batterie fondre comme neige en pleine canicule !

😁

@Scooby-Doo

Preparez vous aussi à vendre vos macbook pro 8gb (qui en valent 16 car c’est apple) pour des modèles 32 ou 64gb 🙂

@SidFik,

« Preparez vous aussi à vendre vos macbook pro 8gb (qui en valent 16 car c’est apple) pour des modèles 32 ou 64gb 🙂 »

👍

Et pendant ce temps, Microsoft nous sort des Surfaces “spécial IA” conçus pour les entreprises avec 8 Go de base seulement !

Et on se moque des modèles faméliques de Apple ! Cherchez l'erreur…

😁

@Scooby-Doo

Il me semble que les IA de MS comme celle de Samsung ou Google fonctionne en très grande majorité sur des fonctionnalités Cloud. MS peut mettre 8Go (une hérésie sur un PC, comme sur un Mac, en 2024) et clamer haut et fort qu'elle a un matériel estampillé "IA".

Cet IA washing est assez pénible alors qu'on en utilise quotidiennement depuis quelques années déjà. Visiblement, ça fait vendre alors ...

@zearno,

« Il me semble que les IA de MS comme celle de Samsung ou Google fonctionne en très grande majorité sur des fonctionnalités Cloud. »

👍

Je confirme pour Microsoft qui a la bonne infrastructure pour déployer de l'IA infonuagique partout…

« MS peut mettre 8Go (une hérésie sur un PC, comme sur un Mac, en 2024) et clamer haut et fort qu'elle a un matériel estampillé "IA". »

👍

Mais cela reste une hérésie quoi qu'il arrive ! Matériel estampillé “IA”, c'est de la mercatique de bas niveau comme sait très bien faire Microsoft aussi…

« Cet IA washing est assez pénible alors qu'on en utilise quotidiennement depuis quelques années déjà. Visiblement, ça fait vendre alors ! »

👍

C'est tendance et je confirme c'est assez “très pénible” !

J'attends avec une certaine impatience le dévidoir de rouleau à papier toilette avec IA intégrée !

La doxa des escrologistes est trop souvent la même :

Pourquoi faire simple et non taxé quand on peut faire super compliqué et surtaxé !

Après la multi catastrophes écologiques des voitures électriques, attaquons-nous à l'aéronautique à base d'hydrogène et ses fuites à tous les étages ?

😁

La revue à comité de lecture (Derwent et al., 2001) a essayé de déterminer la valeur du PRG de l’hydrogène en sommant les PRG du méthane et de l’ozone troposphérique induits par un excès d’hydrogène dans l’atmosphère.

Ces derniers ont une contribution respective de 3,4 (PRGCH4) et 2,4 (PRGO3) donnant une valeur du PRG de l’hydrogène de 5,8 sur une période de 100 ans.

Cette valeur est celle également reprise par le GIEC dans leur rapport de 2007 (IPCC, 2007).

Récemment, une étude du BEIS (qui n’a pas été publiée dans une revue scientifique à comité de lecture) a recalculé ce PRG (sur 100 ans) en considérant un PRG de 4,7 du méthane troposphérique, de 3,2 pour l’ozone troposphérique, et de 3 pour la vapeur d’eau stratosphérique (dont l’impact était jugé marginal jusqu’ici), donnant ainsi une valeur de PRG de l’hydrogène 10,9 sur 100 ans, avec une incertitude de ± 5.

Pourtant, dans les quelques articles parus sur le sujet, le chiffre d’un PRG du dihydrogène plus de 200 fois supérieur à celui du CO2 revient souvent.

Pour comprendre ce qu’il y a derrière cette valeur, il faut garder en tête qu’en matière d’émissions de gaz à effet de serre, la molécule étalon est le CO2 (on compte en « équivalents CO2 »), dont le PRG est toujours considéré égal à 1, quel que soit la période prise en compte.

Seulement, l’hydrogène possède une durée de vie dans l’atmosphère d’environ 2 ans(2) contre environ 100 ans pour le CO2.

Sur ces 2 ans, les effets d’un surplus d’hydrogène dans l’atmosphère seront bien plus importants que sur une période de 100 ans, expliquant la valeur de 200 qui est parue.

Or, se référer au PRG instantané ou sur une période d’environ 2 ans, n’a pas de sens au regard des phénomènes d’accumulation atmosphérique des gaz à effet de serre et des changements climatiques.

De manière générale, il apparaît peu pertinent de donner un PRG sans la période prise en compte, faute de quoi sa valeur est dépourvue de sens.

Néanmoins, au regard de l’urgence climatique et de la trajectoire des émissions anthropiques cumulées, il peut paraître légitime considérer une période plus courte que les 100 ans conventionnels (PRGH2 = 10,9).

L’analyse du PRG de l’hydrogène sur une période de 20 à 30 ans présente un intérêt majeur, et France Hydrogène espère que des études et publications scientifiques porteront prochainement sur ce sujet.

Dans l’étude déjà mentionnée, le BEIS estime un PRGH2 sur 20 ans de 32,6.

😁

Pensez au paracétamol en lisant leurs explications !

Des explications oubliant dès le départ la densité énergétique 4 fois inférieur de l'hydrogène sur le kérosène !

Il faut donc 4 fois plus de carburant !

Cela change tous leurs calculs mais on va vite oublier ce détail gênant !

La “combustion” de l'hydrogène produit de la vapeur d'eau, un gaz à effet de serre !

Surtout que l'on ne sait pas concevoir une filière étanche ! Cela fuit à tous les étages…

🤪

Question subsidiaire négligeable :

La proto atmosphère était constituée de quasiment 100 % de Co2 liée à l'activité intense des volcans !

Et pourtant la planète s'est sortie d'elle-même de cet effet de serre grâce à l'apport d'oxygène par les cyanobactéries sans aucune intervention humaine !

Cherchez l'erreur !

😁

@ Scooby-Doo

> @smog,

>> « Je croyais qu'Apple était larguée sur l'IA... »

> Elle l'est totalement !

> Elle a au moins 7 ans de retard sur les travaux publiés par Google

> Et pendant ce temps, Microsoft...

Visiblement vous avez raté un épisode en 2017 quand Apple a étrenné avec son A12 "Bionic" le premier Neural Engine* (associé à CoreML) pour l'iPhone XS.

« Cherchez l'erreur ! »

🤪

(*) Le Neural Engine n'est rien d'autre qu'un NPU.

@marc_os,

« Visiblement vous avez raté un épisode en 2017 quand Apple a étrenné avec son A12 "Bionic" le premier Neural Engine* (associé à CoreML) pour l'iPhone XS. »

Dit celui qui confond LLM, SLM et IA à domaine restreint !

Oui et c'était donc optimisé pour faire de l'inférence sur LLM ?

C'était pour de l'IA à domaine ultra restreint comme du traitement d'amélioration pour une photo ou la webcam par exemple !

🤪

Donc à vous lire, Apple a pris 7 ans de retard pour sa LLM alors qu'elle avait déjà la bonne unité de calculs dans ses processeurs mobiles avec faille intégrée ?

C'est encore pire ! Aucune excuse…

Donc à vous lire, le A12 va être éligible à la MM1 !

On prend les paris que non ?

😁

« Cherchez l'erreur ! »

Cher marc_os, nous cherchons tous l'erreur en ce bas monde… et Microsoft l'a visiblement trouvée !

👌

Finalement depuis le début de la micro informatique c'est le même débat : en autonomie ou à distance ; et la même réponse : ça dépend pour quoi faire.

@yod75,

« Finalement depuis le début de la micro informatique c'est le même débat : en autonomie ou à distance ; et la même réponse : ça dépend pour quoi faire. »

👍

Exactement ! La solution parfaite n'existe pas…

C'est un éternel débat et on a pas fini de se chamailler à ce sujet !

😁

Un Devonthing dopé à l’IA et fonctionnant exclusivement en local.

👍

C'est ça la super annonce sur l'IA d'Apple? Reconnaitre des objets sur une photo? Et pouvoir les lier? Sérieux?

"On lui demande ensuite combien il faut s’attendre à payer pour tout cela"

La ça va être rigolo... entre 50 et 500, ça dépend de l'endroit... Ca va être de la balle super utile...

J'ai l'impression que cette annonce démontre surtout à quel point Apple part de loin, et qu'elle n'hésitera pas, tout comme pour le moteur de recherche par défaut, à vendre ses utilisateurs à Google, vous savez, ce grand Satan....